Roberto Renzetti

CAPITOLO III

1 – UNO SGUARDO SULL’ 800: RAPPORTI FRA SCIENZA, TECNICA, VITA CULTURALE E CIVILE NELLA PRIMA META’ DEL SECOLO

La complessità degli avvenimenti, sia politico-economici sia tecnico-scientifici, che si susseguono nel corso dell’800 è tale da sconsigliare, nell’ambito degli scopi di questo lavoro, un’indagine che abbia una qualche pretesa di completezza. Cercherò, per quanto possibile, di cogliere gli elementi che ritengo più significativi, rimandando alla vasta bibliografia esistente per tutti gli aspetti e gli sviluppi particolari. Su alcuni punti comunque ritengo sia necessario soffermarsi, soprattutto per cercare di capire più a fondo le problematiche che alla fine del secolo porteranno all’affermazione della Relatività einsteniana. In questo senso mi occuperò con qualche dettaglio della nascita e degli sviluppi dell’elettromagnetismo e di alcune questioni di ottica e di termodinamica.

Anche se non l’ ho teorizzato, credo si sia capito, da quanto precedentemente scritto, che non ritengo si possa cogliere nella sua interezza il processo di crescita delle conoscenze e di articolazione dei dibattiti, dispute o controversie, senza avere come riferimento costante l’evolversi ed il dialettico intrecciarsi tra progresso delle scienze e delle tecniche con storia sociale e civile dei popoli. Nessuna pretesa di originalità quindi nel ricercare anche ora alcuni aspetti dell’interazione suddetta; solo convinzione di fornire elementi utili ad un proficuo approfondimento.

I primi anni del secolo XIX sono segnati, dal punto di vista politico-militare, dalle armate napoleoniche che dilagano in tutta Europa con continue guerre, mai nella storia precedente così sanguinose. Se da una parte la breve vicenda napoleonica scosse la vecchia Europa, retrograda e quasi sempre governata dall’assolutismo (illuminato o meno), diffondendo ideali di libertà, insieme ad una concezione di stato moderno con leggi ispirate ai diritti ed ai doveri del cittadino, d’altro canto essa urtò contro gli spiriti nazionali e, anziché contribuire al diffondersi degli ideali universali dell’illuminismo, generò una massiccia rivolta contro di essi sia da un punto di vista ideale che politico. In ogni caso la politica di Napoleone, fino al suo crollo definitivo (Waterloo, 1815), riuscì ad esportare alcune radicali trasformazioni negli apparati amministrativi degli stati che, già realizzate in Francia, ben presto divennero patrimonio di gran parte dell’ Europa.

In questa epoca la scienza francese, sorretta da massicci finanziamenti al fine di servire le armate napoleonicbe, fece notevoli balzi in avanti. Le scuole tecniche nate durante la Rivoluzione ebbero un notevole impulso. Una generazione di scienziati si formò in esse ( Malus, Arago, Poncelet, Cauchy, Sadi Carnot, Gay-Lussac, Thenard, Dulong e Petit). Inoltre nacquero altre scuole e questo fiorire di iniziative, cui partecipavano come insegnanti i massimi scienziati dell’epoca (Monge, Laplace, Lagrange, Berthollet, …), portò sempre di più ad affermare l’attività scientifica come professione. Fare lo scienziato assunse il significato di lavorare per lo sviluppo tecnico-economico-militare del Paese. Per questo si era pagati. Come conseguenza di ciò e proprio perché dallo studioso, a questo punto, si richiedevano prodotti di sempre più immediata utilizzazione, nacque la specializzazione scientifica. Il filosofo naturale, che si occupava con maggiore o minore successo di troppe questioni abbracciando con le sue ricerche e speculazioni campi molto distanti tra loro, andava via via scomparendo. Certamente rimanevano i Laplace ed i Gauss, ma erano gli ultimi residui della formazione in epoca precedente. Da questo momento e fino a quando le difficoltà che nasceranno all’interno delle singole discipline non imporranno una revisione generale trascendente la disciplina medesima, ognuno coltiverà le sue ricerche particolari sempre più specializzate e sempre più chiuse alla comunicazione reciproca. (128) La separazione tra scienza e filosofia, fatto del quale ancora oggi discutiamo, si realizzò in questo periodo. Gli ideali illuministici che postulavano l’unità del sapere cozzavano ora contro le esigenze militari e produttive. La scienza va sempre più legandosi con il mondo della produzione ed in questo secolo assistiamo al ribaltamento di quanto avvenuto nel secolo precedente; è ora la scienza che razionalmente studia a tavolino i prodotti tecnologici necessari all’aumento della produzione, all’accrescimento dei potenziali aggressivi e qualche volta difensivi degli stati.

” La scienza deve ora attestarsi su canoni metodologici che ne legittimino la ricerca di nuovi standards di esattezza e di rigore, sia manuali che teorici, giustificando lo studio delle leggi naturali e delle loro applicazioni non più in base all’illusione illuministica di essere direttamente uno stimolo per la produzione, ma piuttosto asserendo l’autonomia e la necessità di tale ricerca in quanto valida in sé e destinata prima o poi ad avere applicazioni utili.” (129)

La filosofia che comprenderà e teorizzerà questi Ideali sarà quella del Positivismo che, prima dell’ enunciazione di Comte (1798-1857), (130) “si instaura di fatto come atteggiamento generale e come metodo di lavoro nell’ambito dell’Ecole.” Il Positivismo postula la separazione completa della scienza dalla teologia (laicità dell’uomo e del mondo) ed il netto primato della scienza su altre forme di conoscenza umana. (131) La scienza offre una vasta gamma di risultati ‘positivi’ ma sono soprattutto i suoi metodi che permetteranno il superamento delle argomentazioni ipotetiche, infondate, inverificabili e perciò irrealizzabili. L’adozione di un metodo rigoroso, controllato e comune, il raggiungimento di un’ideale scienza unificata che, nel rispetto delle singole discipline, superi tutti i difetti dell’eccessiva specializzazione e della mancanza di interdisciplinarietà. La scienza è lo strumento indispensabile al progresso dell’umanità. La sua evoluzione permetterà all’uomo di risolvere tutti i suoi problemi di lotta per l’esistenza in una natura sempre meno ostile proprio perché la scienza sempre più è riuscita a sottometterla ai suoi voleri. In questo contesto la filosofia assolve, per Comte, un ruolo importante di ordinatrice e correttrice degli eccessi di specializzazione fino ad arrivare ad un ruolo di promotrice dell’integrazione dei vari risultati che scaturiscono dai vari campi di ricerca.

E tutto ciò proprio nel momento in cui molti scienziati, come dicevamo, sempre più si disinteressavano di filosofia, ritenendo le discussioni sull’argomento troppo generali, quindi generiche e perciò sterili. Questo atteggiamento, spesso definito come ‘ positivistico’, fu osteggiato dagli stessi positivisti ed al suo diffondersi contribuirono molto di più le correnti di pensiero che più decisamente si professavano antipositivistiche. (132) Il disinteresse sempre maggiore da parte dello scienziato per i problemi dell’uomo, con l’ autogiustificazione di far scienza e di stare comunque lavorando per il bene dell’umanità al di sopra di ogni bega contingente, al di sopra delle parti, fu uno degli aspetti più rilevanti ed una delle ‘tentazioni’ più forti dell’800. Basti pensare che ancora oggi ci troviamo a discutere, soprattutto dopo il 1968, della questione della “neutralità” della scienza e della “responsabilità sociale dello scienziato”. (133)

Ma ritorniamo a quanto tralasciato qualche riga più su. Abbiamo parlato del grande impulso che napoleone dette alla ricerca scientifica. In concomitanza con ciò, proprio agli inizi del secolo, in Francia si ebbe una grande ripresa dell’attività pratica (tralasciata, come abbiamo visto, per tutto il ‘700), gli scienziati francesi volsero i loro interessi alla scienza sperimentale ed empirica proprio per soddisfare le impellenti richieste degli eserciti di Napoleone. La caduta di quest’ultimo, il Congresso di Vienna (1815), la Santa Alleanza iniziarono quel periodo che va sotto il nome di Restaurazione. Le forze più conservatrici, legate soprattutto alla nobiltà terriera dell’ “ancien régime”, tentarono di ‘restaurare’ l’ordine sociale ed il potere politico precedente l’esplosione rivoluzionaria. Almeno fino al 1848 il tentativo riuscì e si ripercosse molto gravemente sulla vita scientifica e culturale che venne sottoposta a rigidi controlli. Ma un puro e semplice ritorno al passato era anacronistico. Le coscienze erano maturate e cresciute, era possibile reprimere ma non convincere. In questa fase la borghesia riprese coscienza del suo ruolo motore per lo sviluppo della società. I primi moti contro i nuovi oppressori si ebbero nel 1820-21 (forze liberali); e quindi nel ’48 (liberali + democratici), dopo un’importante parentesi rivoluzionaria (la Comune di Parigi), proprio la borghesia riprenderà quasi ovunque il potere. (134) Durante questa prima metà del secolo le vicende legate allo sviluppo della scienza, della tecnica, della cultura in generale e delle forze produttive si differenzia abbastanza da paese a paese.

In Francia, abbiamo già visto che, a partire dalla Rivoluzione c’è una grande ripresa dell’ attività pratica che comporta una trasformazione notevole della scienza. Uno dei primi compiti, di enorme impegno, che gli scienziati francesi (Monge, Borda, Lagrange, Laplace, Delambre, Coulomb, Berthollet, Lavoisier) si trovarono ad affrontare fu l’unificazione dei pesi e delle misure con l’introduzione del sistema metrico decimale. I lavori iniziarono nel 1793 e si conclusero nel 1799. Questo nuovo sistema fu rapidamente accettato da molti Stati e comportò notevolissime facilitazioni ai commerci. Altri compiti immediati che gli scienziati dovettero affrontare, e che non avevano nulla a che fare con la fisica-matematica settecentesca, erano immediatamente suggeriti dalle esigenze belliche. Monge studiò le questioni riguardanti la fusione e la perforazione dei cannoni. Fourcroy si occupò, come già aveva fatto Lavoisier (nel frattempo caduto sotto la ghigliottina), di sviluppare tecniche atte ad estrarre il salnitro per gli esplosivi dal letame. Allo stesso fine lavorava Berthollet ma con il clorato di sodio e Morveau mediante ossidazione dell’ammoniaca.

Certamente i problemi che si ponevano erano diversi da quelli teorici affrontati durante il ‘700. Questa tendenza ebbe un maggior impulso durante il periodo napoleonico ed in concomitanza con ciò anche l’evoluzione tecnica delle industrie francesi fece notevoli balzi in avanti.

Il periodo della Restaurazione vide in Francia un certo successo delle filosofie idealistiche e romantiche che si diffondevano dalla Germania. Personaggi come Chateaubriand, Lamartine, Madame de Staël potranno dar sfogo ad anacronistiche posizioni metafisiche con decisi caratteri antiscientifici. Per la verità la scienza fu poco toccata da tutto ciò la tradizione dell’ École era troppo forte ed ancora per anni riuscirà a produrre importantissimi risultati. (135) Ora però viene a mancare lo stimolo diretto alla produzione che gli imprenditori borghesi avevano fornito negli anni precedenti. Dopo un poco il filone si inaridì e per vari anni non produsse altro che la solita sistemazione dei risultati precedentemente raggiunti (e questo fatto trovava inoltre una teorizzazione nella filosofia del Positivismo che non accettava nessuna elaborazione ipotetica che andasse al di là dei fatti noti).

In Gran Bretagna, parallelamente a quanto avveniva in Francia nel periodo rivoluzionario e napoleonico, l’attività empirica degli scienziati passava un periodo di crisi. Lo scienziato del Regno Unito, al contrario di quello Francese, spesso langue in miseria non godendo della protezione dello Stato. Non si dispone di finanziamenti per formare scienziati professionisti in scuole pubbliche. L’attività scientifica, anche qui, cambia segno e gradualmente inizia ad interessarsi di questioni di carattere teorico. L’avvertita necessità di cambiamento trovò in Rumford un fecondo interprete, ma i suoi tentativi di rinnovamento, nell’ambito dell’organizzazione e dei metodi delle società scientifiche, non riuscirono a farsi strada in un ambiente restio a mettere in comune le innovazioni tecniche e scientifiche per la paura di concorrenze o plagi sul piano dei brevetti industriali. Riuscirà in parte Davy nel compito che si era prefisso Rumford. Egli otterrà finanziamenti ma presentando la scienza come un qualcosa che oltre ad utile può essere anche divertente.

In questo paese la Restaurazione non avrà che effetti marginali. Si tratta di contrasti tra la borghesia latifondista ed industriale sulla rappresentanza parlamentare spettante a ciascuna. Fino al 1831, anno in cui gli industriali ottengono una riforma elettorale che dà loro maggiore potere, è la borghesia latifondista che guida il paese, su livelli arretrati rispetto alle spinte innovatrici, “agitando lo spauracchio della Rivoluzione Francese”.

Abbiamo già detto della antiquata organizzazione della scienza nelle istituzioni di questo periodo (alla quale aveva in parte contribuito l’isolamento in cui si era chiusa la Gran Bretagna nel secolo precedente). Anche le scuole pativano gli stessi mali. Se si eccettuano le relativamente più giovani università scozzesi, le più prestigiose università inglesi (Oxford e Cambridge) impartivano insegnamenti vecchi e tradizionalisti sotto il controllo culturale di autorità clericali. Ed il dominio dello Stato e delle autorità religiose si cominciò a far sentire in tutti i campi. La scienza veniva sempre più considerata come un qualcosa di eminentemente teorico, visto che tutti i più prestigiosi strumenti della Rivoluzione Industriale provenivano da modesti tecnici senza una preparazione elevata. Si iniziarono comunque a fondare nuove scuole (gli Istituti di Meccanica) per fornire preparazioni diverse; si iniziò ad insegnare la matematica col più semplice simbolismo leibniziano; ma soprattutto si colse la necessità dello scienziato professionista (le ricerche che si dovevano sviluppare erano così complesse che soltanto lavorandovi a tempo pieno c’era la speranza di ricavarne qualcosa e per far ciò occorreva un finanziamento dello Stato o di una grande industria); si fondarono società scientifiche (ad es. l’Associazione Britannica per il Progresso della Scienza – 1831) diverse da quelle tradizionali e pure un tempo prestigiose; fatto però molto importante è che tutto ciò iniziò e si realizzò dall’iniziativa e dai finanziamenti di privati. Solo intorno alla metà del secolo l’intera situazione cominciò decisamente a migliorare portando la situazione strutturale ed organizzativa britannica ai livelli di Francia e Germania che, come vedremo tra poco, era nel frattempo emersa prepotentemente) e facendo di nuovo assumere alla Gran Bretagna una posizione di primato. (136)

Dal punto di vista tecnologico ed in concomitanza con la relativa stasi dell’industria non si conseguirono i risultati clamorosi della seconda metà del ‘700 ma si lavorò al perfezionamento ed alla migliore ed articolata utilizzazione di quanto già noto. Nell’ industria tessile alcuni miglioramenti tecnologici portarono, tra il 1800 ed il 1830, ad una espansione enorme della domanda a seguito di ribassi clamorosi nei costi di produzione. La generale sostituzione della forza motrice idraulica con quella a vapore comportò la realizzazione di centinaia di opifici non più in zone servite da corsi d’acqua ma in città che, conseguentemente, vissero imponenti fenomeni di inurbamento. (137) L’impiego poi del vapore nei trasporti ed in particolare nelle ferrovie, (138) oltre agli ovvi ed incredibili benefici pratici, produsse anche notevoli effetti psicologici sulle nozioni di tempo e distanza.

In Germania, infine, tra la fine del ‘700 e la prima metà dell’ ‘800, si ha m notevolissimo risveglio della vita culturale in netto contrasto con l’arretratezza di fondo delle strutture economiche, politiche e sociali. Abbiamo già detto di Kant, dello Sturm und Drang e della nascita del Romanticismo. Non è certo questa la sede per indagare la complessità, e l’eterogeneità del pensiero tedesco, (139) delle posizioni assunte, dei temi affrontati e degli sviluppi che, in sede speculativa, ne conseguirono. Basti solo dire che i principali indirizzi di pensiero assunsero caratteristiche sempre più antilluministiche e nazionalistiche. E se da una parte Fichte, facendo confluire il suo idealismo nei temi più. spiccatamente romantici, si rivolgerà. alla nazione tedesca perché insorgesse contro le truppe napoleoniche che invadevano la Germania, dall’ altra Hegel (l770-l83l) pretenderà, di determinare le leggi della natura a priori, ricavandole semplicemente su basi metafisiche. (140) A lato di ciò, negli ‘spiriti migliori’ i temi romantici si legavano alle legittime aspirazioni di libertà, ed indipendenza dei popoli. La Germania è un paese diviso in una miriade di piccoli Stati. Ma già nei primi decenni del secolo si fa avanti la Prussia, il più industrializzato tra gli Stati tedeschi, come polo di aggregazione. Della complicata storia della nascita dello stato tedesco, (141) elemento importante fu la fondazione (da parte dell’ imperatore Federico Guglielmo III) dell’ Università di Berlino (l8l0). Questa Università, insieme all’ attività dei ‘filosofi della natura’ che si ispiravano direttamente alla Naturphilosophie di Schelling, fu alla base della rinascita culturale della Germania e della successiva acquisizione da parte di questo Paese del primato scientifico su tutto il mondo. Fu proprio Oken, uno dei filosofi della natura, che fondò nel 1822 la prima società scientifica che rappresentò la rinascita della ricerca scientifica tedesca, su basi più empiriche e sperimentali di quanto fino allora aveva comportato l’eredità di Leibniz. Sulla strada da lui aperta altri si mossero e ben presto, ad imitazione della Francia, sorsero una miriade di scuole politecniche. Cattedre di scienze cominciarono a venir istituite in tutte le università tedesche e, a partire dalla metà del secolo, le scuole sia industriali che commerciali iniziarono a sfornare una gran quantità di tecnici altamente specializzati. E tutto ciò era proprio finalizzato allo sviluppo dell’ industrializzazione del Paese che, al contrario di quanto avvenuto in Gran Bretagna, non fu promossa da privati ma per diretta iniziativa dello Stato che contemporaneamente, mediante lo sviluppo massiccio dell’ istruzione pubblica, cercava da un lato “di elevare il livello culturale del popolo per incrementarne i bisogni materiali e spirituali e per portare il semplice operaio a comprendere i nuovi sistemi di produzione meccanizzati; d’altro lato di formare una categoria di tecnici in grado di soddisfare le maggiori esigenze tecniche e scientifiche poste dall’ industria.” (142) In questa dialettica tra Stato, imprenditori privati, popolo, sviluppo industriale ed istruzione, via via si realizzò una maggiore partecipazione della borghesia industriale alle scelte politiche del paese e conseguentemente si conquistarono importanti riforme costituzionali. In definitiva, intorno alla metà dell’ ‘800, è la borghesia industriale che detiene ovunque il potere economico. La pressione di questa borghesia per avere in mano anche il potere politico porterà alle vicende del ’48 che sancirono, praticamente ovunque, il suo trionfo. Con il terreno preparato per il decollo della seconda Rivoluzione Industriale si erano creati profondi cambiamenti economici e sociali che se da una parte avevano definitivamente affrancato l’Europa dall’ Ancien Regime, dall’altro avevano creato i presupposti per l’emergere di una nuova classe sociale: il proletariato, l’esercito degli operai dell’industria che dispongono solo della propria forza lavoro. L’affermazione della borghesia aveva creato la sua classe antagonista che, proprio a partire dal ’48, dette vita a tutti quei moti di ribellione sociale per migliori condizioni di vita che schematicamente si possono riportare alla nascita del socialismo scientifico di Marx (1818-1883) ed Engels (1820-1895) e che portarono (l917) alla prima Rivoluzione proletaria della storia: la ormai definitivamente tramontata Rivoluzione Russa.

Dal punto di vista infine del progresso tecnologico legato a quello scientifico ci sono alcune osservazioni che meritano di essere riportate. Innanzitutto c’è da osservare che gli imponenti sviluppi della tecnica del ‘700 e dei primi anni dell’ ‘800 riuscirono a mettere a disposizione degli scienziati strumenti sempre più perfezionati e precisi che tra l’altro permisero di percorrere strade assolutamente imprevedibili fino a qualche anno prima. C’è poi da notare che, soprattutto nella prima metà del secolo, c’è un generale riconoscimento dell’utilità del progresso tecnico che, si ammette, non può più essere affidato ad artigiani, che lavorano su basi esclusivamente empiriche, ma ha bisogno di essere sottoposto a trattamento teorico per ricavare da esso il massimo possibile in un contesto più ampio ed organico.

2 – LA NASCITA DELL’ELETTROMAGNETISMO (SCHELLING ED OËRSTED) E TENTATIVI DI RICONDURRE I NUOVI FENOMENI ALL’AZIONE A DISTANZA

[Da questo capitolo ho tratto il materiale per l’articolo n° 11 dell’indice: “Concezioni particellari nel XVII e XVIII secolo …”. Rimando pertanto ad esso. Salteranno anche le note che vanno dalla 143 alla 161].

3 – LE TEORIE ELETTROTONICHE NELLA GERMANIA DELLA PRIMA METÀ DELL’OTTOCENTO: WILHELM WEBER (1804 – 1890)

Le teorie elettrodinamiche, matematizzate da Laplace, Poisson ed Ampère, suscitarono un grande interesse negli scienziati tedeschi. A partire dal 1840 si iniziarono a proporre, in Germania, varie teorie elettriche che sostituivano ai fluidi cariche di elettricità di segno opposto, fluenti in versi opposti con uguale densità e velocità. Tra queste particelle cariche si dovevano prendere in considerazione delle forze agenti in ragione della carica trasportata dalle particelle stesse e della loro velocità. (162) Per mezzo di questa teoria, come fa osservare Rosenfeld, (163) Weber riuscì a ricondurre sia le leggi dell’ elettrodinamica che quelle dell’induzione elettromagnetica (si veda più oltre) ad una sola formula che fornisce la forza che si esercita tra due elementi di carica q1 e q2 la cui distanza r vari con il tempo in conseguenza del moto delle cariche. La formula di Weber, nel caso di cariche ferme, fornisce la legge di Coulomb mentre, applicata al calcolo delle azioni elettrodinamiche tra correnti, fornisce la legge di Ampère appena vista (il moto, dunque,origina delle modificazioni nelle forze !). In questa formula compare un parametro c che rappresenta il rapporto fra l’unità elettrostatica e l’ unità elettrodinamica di carica e l’introduzione di due distinte unità di carica elettrica è una diretta conseguenza dell’aver assunto la corrente come flusso di cariche elettriche.Questo parametro c è di fondamentale importanza; esso fu misurato per la prima volta proprio da Weber, insieme a Kohlrausch, nel 1855 nel corso di una complessa ed accurata serie di misure fatte per la determinazione assoluta delle varie grandezze che comparivano nei fenomeni elettrici e magnetici. Weber e Kohlrausch trovarono per c il valore di 3,11×1010 cm/sec, coincidente con quello che, negli stessi anni, era stato trovato da Fizeau e da Foucault per la velocità della luce nel vuoto in esperienze di natura completamente diversa (si veda più oltre). Questa coincidenza di valori fu notata da Weber (166) ma egli, nel contesto della sua fisica, non dette molta importanza alla cosa. (167) Oltre a ciò, come osserva D’Agostino, “come conseguenza della forma delle leggi di forza statiche e dinamiche, espressa dalla legge elementare di Weber, il rapporto elettromagnetico o viene a configurarsi anche come quella velocità limite a cui debbono muoversi le cariche affinché le loro azioni statiche vengano equilibrate da quelle dinamiche (168) – questo secondo significato di c, a differenza del primo, non è più citato oggi nei testi perché non rientra nel quadro che ora si dà dell’elettromagnetismo. Ma allora, a metà Ottocento, fu così che si presentò , per la prima volta, il concetto di una velocità limite in elettrodinamica … Fu questo doppio aspetto di c, come velocità della luce e come velocità limite, che a metà Ottocento indusse i maggiori studiosi di elettromagnetismo – Maxwell compreso – ad escogitare metodi per la sua misura.”

Molte obiezioni e di varia natura furono mosse alla teoria di Weber, soprattutto da Helmholtz e Clausius. Queste obiezioni riguardavano principalmente questioni di carattere energetico legate alla compatibilità della formula di Weber con il principio di conservazione dell’energia che in quegli anni si andava affermando (si veda più oltre). (170) La teoria di Weber resse comunque per molto tempo poiché descriveva abbastanza bene i risultati sperimentali che all’epoca si andavano accumulando e perché aveva dimostrato la sua utilità, ad esempio, nei calcoli fatti da Kirchhoff per valutare il ‘movimento dell’ elettricità nei fili’. (171) Affinché la teoria di Weber potesse reggere, potremmo oggi osservare, abbisognava della nozione di potenziale ritardato che tenesse conto del ritardo nella propagazione dell’interazione elettrica. Riemann fu il primo a rendersi conto di ciò (1859) quando affermò che “l’azione non è istantanea, ma si propaga con una velocità costante c“. Sulla sua strada si mosse poi Ludwig Lorenz (172) che ottenne risultati analoghi a quelli che, per altra via, conseguì Maxwell. Egli aprì la sua memoria del 1867 con l’ammissione, derivante – secondo Lorenz – da tutti i fatti sperimentali che si erano accumulati, che le varie forze agenti tra elettricità e magnetismo, tra calore, luce, azioni chimiche e molecolari dovevano essere riguardate come manifestazioni di una e medesima forza che, a seconda delle circostanze, si mostra sotto forme differenti. (173) Questa unità della forza però ci sfugge perché, sempre secondo Lorenz, a seconda dei fenomeni che studiamo ci serviamo, di volta in volta, di ipotesi modellistiche differenti: una volta i fluidi, una volta l’etere, una volta le molecole. Egli propose allora di sbarazzarsi dei modelli (174), che sono più di ostacolo che di aiuto, e di passare a costruire una fisica indipendente da essi. 33 senza far uso di modelli egli si propose di individuare l’ identità tra luce ed elettricità arrivando ad affermare che le vibrazioni della luce sono esse stesse correnti elettriche. Senza dilungarci troppo sull’opera di questo fisico, basti osservare che il risultato cui egli giunse “è che le vibrazioni di una corrente elettrica inducono vibrazioni nelle immediate vicinanze, in completa analogia con quanto accade nel fenomeno di propagazione delle onde luminose.” (175) Per arrivare a questo risultato Lorenz introdusse, come avevamo accennato, i potenziali ritardati. (176) In questo modo egli trovò, in modo più diretto, le stesse equazioni che troverà Maxwell, giungendo alla conclusione “che le forze elettriche richiedono del tempo per viaggiare e che queste forze solo apparentemente agiscono a distanza.” (177) Come mai dunque il programma weberiano, che pure con l’introduzione dei potenziali ritardati portava agli stessi risultati di Maxwell, fu abbandonato? Certamente contribuirono cause diverse, tra le quali, con D’Agostino:

” 1. Un graduale abbandono del quadro esplicativo di Newton ed Ampère non soltanto in elettrodinamica.

2. Una certa qual macchinosità delle formule di Weber nel loro adattamento alla spiegazione di quel tipo di fenomeni elettromagnetici che, alla fine del secolo, saranno al centro dell’ interesse – cioè l’irraggiamento da antenne -, in contrasto con la maggiore semplicità offerta, per gli stessi fenomeni, dalla teoria di Maxwell.

3. La fecondità dimostrata allora dalla teoria di Faraday -Maxwell nel suggerire nuovi esperimenti” (178) proprio perché sostenuta da un’impalcatura modellistica con apparati di maggiore intuibilità.

Resta il fatto che la teoria di Weber, pur muovendosi come sviluppo del programma amperiano, introdusse degli elementi non solo non riconducibili ma addirittura in contrasto con la fisica newtoniana. Mai Newton aveva, neppure ipotizzato, forze che potessero dipendere dalla velocità. Ma d’altra parte lo stesso Ampère aveva introdotto angoli tra elementi infinitesimi di circuito! Anche se si continuava a richiamarsi a Newton, questi sempre meno era rappresentato dalla fisica che si sviluppava intorno alla metà dell’Ottocento.

In chiusura del paragrafo resta solo da ricordare, per quanto vedremo più avanti a proposito di H.A. Lorentz, che la teoria di Weber fu perfezionata nel 1877 da Clausius che fornì una nuova espressione per la legge di forza fra elettroni. In questa nuova relazione non si ipotizzava più che le cariche elettriche fluenti in verso opposto dovessero necessariamente avere la stessa velocità ed inoltre le stesse velocità delle cariche erano considerate rispetto ad un etere immobile risultando quindi velocità assolute, al contrario di quanto accadeva nella formula di Weber dove le velocità erano relative.(178bis)

4 – CRITICA DELL’AZIONE A DISTANZA E FORMULAZIONE DELL’AZIONE A CONTATTO: L’OPERA DI FARADAY

5 – L’AFFERMAZIONE DELL’AZIONE A CONTATTO: MAXWELL, LA FORMALIZZAZIONE DELL’ELETTROMAGNETISMO E LA NASCITA DELLA TEORIA ELETTROMAGNETICA DELLA LUCE

[Da questi due capitoli ho tratto il materiale per l’articolo n° 16 dell’indice: “La nascita della teoria di campo i lavori di Faraday e Maxwell”. Rimando pertanto ad esso. Salteranno anche le note che vanno dalla 179 alla 268].

NOTE

(128) Nascono in questo periodo: la matematica pura, la geometria pura, l’analisi pura, la fisica-matematica come disciplina separata dalla matematica, la chimica separata dalla fisica, l’elettrologia come scienza a sé, la termodinamica.

(129) Baracca e Livi in Bibl. 24, pag. 15.

(130) I lavori di Comte saranno pubblicati in sei volumi tra il 1830 ed il 1842. Si osservi che Comte proveniva dall’École.

(131) 1 fatti vanno spiegati con i fatti e dal rapporto continuo e costante con i fenomeni nasce la legge fisica. Bisogna rifiutare ogni postulato metafisico e quindi le cosiddette «ipotesi ad hoc». Naturalmente si nega l’esistenza degli atomi che non sono un fatto ma una mera ipotesi. Si noti che Comte inizia una critica alla pretesa di voler ridurre tutte le scienze alla matematica; secondo il nostro è necessario che ciascuna scienza si sviluppi autonomamente e quindi, solo dopo che ciascuna sarà stata sviluppata a fondo, si tratterà di mettere insieme i risultati in un grande lavoro di sintesi.

(132) Vedi Bibl. 17, Vol. 4, pagg. 12-13. Visto l’atteggiamento assunto da molti scienziati, capeggiati da Bohr, agli inizi del nostro secolo ed in particolare le vicende della Scuola di Copenaghen, in relazione alla nascita ed all’affermazione della meccanica quantistica, sarebbe più corretto, oggi, definire l’atteggiamento dello scienziato che si disinteressa ai problemi filosofici come ‘neopositivista’. Per approfondire in parte questi problemi si può vedere bibl. 57, pagg. 189-233. Sull’argomento vi sono poi degli interessantissimi lavori di F. Selleri (Università di Bari) ma sono di difficile reperimento.

(133) Allo scopo si può vedere bibl. 53, pagg. 65-89 (contributo di Petruccioli e Tarsitani) e Bibl. 58. Ho fatto cenno a ciò proprio perché Einstein sarà scienziato di grande impegno morale e civile.

(134) Da questo punto in poi per chi volesse seguire con maggiori dettagli e con una impostazione da me completamente condivisa, le complesse vicende dei rapporti tra scienza, tecnica, industria e vicende politiche può senz’altro rivolgersi all’interessantissimo saggio di Baracca, Russo e Ruffo di Bibl. 54. Un’analisi più concisa, sugli stessi argomenti e con lo stesso taglio, si può trovare nel saggio di Baracca e Livi di Bibl. 24.

Un’impostazione diversa dei problemi in discussione, in cui però si ricostruisce la sola storia interna, con un taglio che io non condivido, ma che credo vada conosciuto, si può ritrovare nel lavoro di Bellone riportato in Bibl. 59.

Per capire poi meglio il senso della diversità delle impostazioni si può , ad esempio, vedere a confronto i tre articoli seguenti:

E. Bellone – La scienza ed i suoi nemici – Sapere n° 802 (luglio ’77)

E. Donini, T. Tonietti – Conoscenza e pratica – Sapere n° 808 (febbraio ’78).

A. Baracca. R. Livi, S. Ruffo ed altri – Nemici per la pelle – Sapere n° 808 (febbraio ’78)

Si osservi che rispetto al suo contributo (1972) a Bibl. 53 (La Rivoluzione scientifica dell’ ‘800), Bellone sembra aver cambiato opinione.

(135) Si pensi ai risultati – dei quali discuteremo più avanti – raggiunti da S. Carnot nello studio delle macchine termiche, da Ampère nella fondazione dell’elettrodinamica e da Fresnel nell’affermazione della moderna teoria ondulatoria della luce.

(136) A partire dal 1846 fu Kelvin che dette il contributo decisivo alla modernizzazione dell’insegnamento scientifico con l’introduzione della parte sperimentale nel lavoro di formazione di uno scienziato.

(137) Un’altra innovazione fondamentale fu l’introduzione dell’illuminazione a gas nelle grandi fabbriche; essa ‘permise’ di prolungare il lavoro fino a notte inoltrata.

(138) Solo verso la fine del secolo l’uso del vapore sulle navi permise il raggiungimento di tonnellaggi paragonabili con quelli delle navi a vela. La prima ferrovia è britannica (1825). Nel 1830 si costruì l’importantissima Liverpool – Manchester.

(139) Tra Romanticismo, Idealismo e Razionalismo. In ogni caso, qui in nota, vale la pena dare un brevissimo cenno della concezione romantica della conoscenza della natura.

” L’ideale romantico [postula] una completa fusione ed unità della ragione umana con il mondo anche al di là delle delle possibilità, e dei dati offerti da quell’analisi e da quell’indagine empirica e razionale care invece al precedente illuminismo, posto sotto accusa dai romantici proprio perché ritenuto troppo innamorato delle distinzioni, della chiarezza, e di classificazioni precise che compromettevano la possibilità di quella intima e dinamica fusione. Esso svolse anche, comunque, nonostante la sua componente irrazionalistica, una funzione di stimolo e rinnovamento scientifico, come nell’opera di Oërsted.” (Baracca e Rossi in Bibl. 56, pag. 197).

Un altro aspetto che emerge in alcuni filosofi romantici è che la mante umana ha dei limiti, oltre i quali non può andare, nella conoscenza della natura. Schopenauer, che è tra questi, sostiene che tutti coloro i qualki non si rendono conto di questi limiti diventano facilmente dei materialisti con una propensione particolare a deridere la religione. Solo la filosofia può permettere di superare i limiti che necessariamente sorgono nell’ambito delle scienze naturali. Il lavoro in cui Schopenauer sostiene queste cose è riportato in Bibl. 61.

(140) È interessante notare che questo ritorno alla metafisica da parte di Hegel, che si accompagna ad uno spirito accanitamente antiscientifico fornirà la base, in Italia, all’Idealismo di Croce e Gentile che tanti danni ha prodotto, tra l’altro alla struttura della nostra scuola (si veda allo scopo Bibl. 39). Occorre comunque osservare che questi danni, a 8o anni di distanza, non solo non sono stati riparati, ma addirittura si vanno rapidamente aggravando.

All’idealismo hegeliano occorre poi risalire per trovare la teorizzazione di tutti gli Stati totalitari: “il benessere e la felicità individuale sono fatti empirici, irrilevanti, che non hanno alcuna importanza se posti al confronto con l’autorità dello Stato. La vera e profonda libertà si realizza esattamente nel suo opposto: in una salutare costrizione capace di realizzare il superiore Spirito etico, la vera volontà sostanziale che manifesta l’idea dello Spirito”. E nell’ammirazione dello stato prussiano (” fra esercito, censura, polizia, galere ed un clero … intrinsecamente amorale”) Hegel esalterà la guerra che ” ha l’alto significato che attraverso di essa si preserva la salute morale dei popoli creando in loro l’indifferenza per lo stabilizzarsi di forme determinate” . Per ulteriori, illuminanti dettagli si veda Forti in bibl. 7, Vol. 5, pagg. 13-16 (da cui provengono le citazioni qui riportate).

(141) Basti qui ricordare che nel 1834 si riuscì a realizzare una Unione Doganale che liberalizzò il mercato interno.

(142) Klemm in Bibl. 22, pag. 271.

*******************************************

(162) L’ipotesi, elaborata nel 1845, è di G. T. Fechner.

(163) Bibl. 65, pag. 1633.

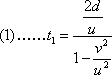

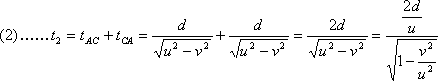

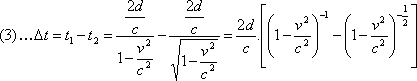

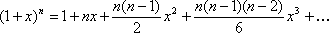

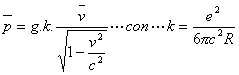

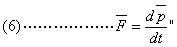

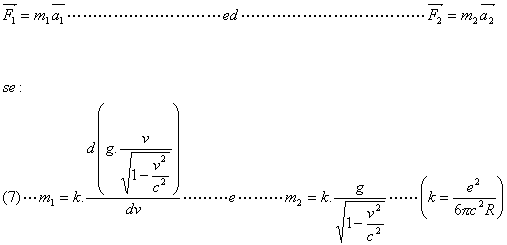

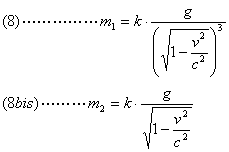

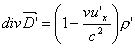

(164) La formula di Weber si scrive:

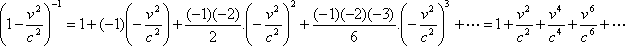

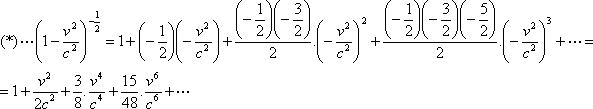

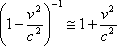

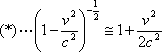

F = q1q2 /r2 . [1 – (1/2c 2)(dr/dt) 2 + (1/c2 ).r.(d2 r/dt2 )].

Poiché (dr/dt)2 rappresenta la velocità, elevata al quadrato, delle cariche, mentre d2 r/dt2 la loro accelerazione, si vede subito che, per cariche ferme, si ha la legge di Coulomb (a meno di un fattore moltiplicativo che dipende dalla scelta delle unità di misura). Per cariche non accelerate, quando cioè d2 r/dt2 = 0, se nella formula risulta c = dr/dt, si vede subito che F = 0, cioè che la forza si annulla. Ciò vuol dire che la forza elettrostatica fa equilibrio alla forza elettrodinamica.

Si osservi che una formula analoga era stata trovata da C.F. Gauss (1777-1855), maestro ed amico di Weber (tra l’altro Weber utilizza proprio il sistema di unità di misura detto di Gauss nel quale la legge di Coulomb – vedi più su – risulta essere F = q1 q2 /r2 ). Egli, come confida in una lettera allo stesso Weber (1845), non la pubblicò poiché non era riuscito a trovare, nella legge di forza tra cariche, “un meccanismo pe il quale la forza stessa non si esercitasse istantaneamente tra di esse, ma si propagasse con velocità finita al medesimo modo della luce”. (Moneti in Bibl. 63, parte II, pag. 145). Gauss riteneva ciò di fondamentale importanza ed annetteva a questa eventuale scoperta la possibilità di essere chiarificatrice per l’intera elettrodinamica.

(165) Per maggiori dettagli sull’ opera di Weber e sui suoi collegamenti con quella di Ampère, si veda Bibl. 60, pagg. 10-13 e Bibl. 65, pagg. 1633-1635. Si noti intanto che, come vedremo meglio più avanti, il parametro c che compare nella formula di Weber discende dall’adozione di un particolare sistema di unità di misura, quello appunto di Gauss (o Gauss-Weber o Gauss-Hertz). In questo sistema si misurano tutte le grandezze elettriche in unità elettrostatiche (u.e.s.) e tutte le grandezze magnetiche in unità elettomagnetiche (u.e.m.), fermo restando il fatto che le tre unità fondamentali sono il centimetro, il grammo-massa ed il secondo.

(166) Fu Kirchhoff che per primo la notò nel 1857. Per la verità c risultava radice di 2 volte la velocità della luce.

(l67) In un suo scritto Weber commenta ciò dicendo: “questo fatto non è tale da accendere grandi aspettative”. Vale appena la pena osservare che, come vedremo, da questo stesso fatto, Maxwell trasse ben altre conseguenze. È anche interessante notare che questo è uno di quei casi in cui da uno stesso fatto, in connessione con termini teorici differenti, si possono ricavare conseguenze diverse.

(168) Si veda .la prima parte della nota 164, quando si discute l’eventualità che c assuma il valore dr/dt.

(169) Bibl. 60, pagg. 11-12. La sottolineatura è mia.

(170) È interessante notare che in una risposta di Weber (1871) ad una obiezione di Helmholtz egli sostiene che l’obiezione non ha senso perché, se essa fosse vera, si dovrebbero avere particelle dotate di velocità superiori a quella della luce (la velocità della luce sembra già affacciarsi come velocità limite). Helmholtz fece anche un’altra obiezione (alla quale Weber non rispose), per rispondere alla quale, però, bisognava ammettere la propagazione con velocità finita delle onde elettromagnetiche (Bibl. 63, parte II, pag. 149).

(171) All’epoca si facevano i primi esperimenti e le prime messe in opera dei telegrafi aerei e sottomarini, i quali ultimi richiedevano la posa di cavi molto complessi da calcolare. Il telegrafo era stato inventato da Ampère e realizzato da Morse nel 1839.

(172) Fisico danese (1829-1891) che non va confuso con Hendrich Anton Lorentz (1853-1928) del quale ci occuperemo nel paragrafo 5 del capitolo 17°.

(l73) Si osservi che, oltre a quanto già visto a proposito di connessioni tra fenomeni di vario tipo, verso la metà del secolo, il fisico italiano Macedonio Melloni (1798-1854) colse l’identità della luce con i fenomeni di radiazione calorifica. Per maggiori dettagli si veda Bibl. 66.

Mi piace soffermarmi un istante su Melloni per ricordarlo, oltre che come grande fisico, il “Newton del calore” come venne definito, (del quale purtroppo si studia poco), come uomo di grandi ideali che partecipò attivamente e sempre dalla parte giusta al Risorgimento italiano (si veda Bibl. citata).

(l74) L’uso dei modelli era stato un punto di forza della fisica meccanicista a partire da Galileo.

(175) Bibl. 63, parte II, pag. 177.

(176) I potenziali ritardati, secondo la definizione di M.B.Hesse (Bibl. 9, pag. 253) sono “potenziali scalari e vettoriali propagantisi in un vuoto con velocità c, in modo che il loro arrivo ad. una distanza r dalla loro sorgente abbia luogo ad un tempo r/c dopo la loro emissione.” Per i dettagli analitici si può vedere bibl. 63, pagg. 178-179.

(177) Ibidem. Si noti che negli sviluppi della teoria di Lorenz non occorre alcun etere.

(178) Bibl. 60, pag. 13. La sottolineatura è mia.

(178 bis) Per approfondire questa parte si veda bibl.112, Vol. 1, pagg. 234-235.

*****************************************

6 – DALLE TEORIE SELLA LUCE ALL’OTTICA DEI CORPI IN MOVIMENTO : ULTERIORI FENOMENI NON RICONDUCIBILI ALLA FISICA DI NEWTON

E’ indispensabile richiamare alcuni fatti lontani per intendere quanto diremo in questo paragrafo. Lo faremo molto in breve e, senza scomodare né Platone né Aristotele, inizieremo a discutere la questione della natura della luce a partire da Descartes. (269) Abbiamo già visto all’inizio di questo lavoro (270) che, per Descartes la materia è estensione. Quindi ogni cosa o fatto che sia esteso ha un comportamento analogo a quello della materia. La luce si estende dappertutto: conseguenza di ciò è che essa deve essere intesa come un qualcosa di materiale che si propaga “istantaneamente come una pressione esercitata dalle particelle di una materia sottile“. Questa materia sottile, che permette la trasmissione delle pressioni, anche là dove non appare materia sensibile, è l’etere, di aristotelica memoria (la quintessenza), inteso come un corpo rigido ideale. Va ben chiarito che la luce non è, per Descartes, costituita dal moto delle particelle sottili, ma dalla loro pressione le une sulle altre in un ‘universo’ tutto pieno (oggi si direbbe; onde longitudinali). L’etere, che riceve una pressione, vibra, come diremmo oggi, intorno alla sua posizione di equilibrio, trasmettendo istantaneamente la pressione che ha ricevuto. (271)

La concezione di Newton è più articolata ed egli, anche se è universalmente noto come padre della teoria corpuscolare della luce, in realtà non prende una posizione precisa ma pone la questione in forma problematica. (272). In certi passaggi sembra evidente una sua adesione alla teoria corpuscolare che fa a meno dell’etere (questo almeno fino al 1671 quando una polemica con Hooke lo orientò verso nuove strade); in altre parti della sua opera (Una nuova teoria sulla luce e sui colori -1672) pare orientato verso la teoria ondulatoria sostenuta dall’etere («Le vibrazioni più ampie dell’etere danno una sensazione di colore rosso mentre quelle minime e più corte danno il violetto cupo; le intermedie colori intermedi»); in altri passaggi poi, come nella Ottica (Libro II, parte III, proposizione XII) del 1704, sembra invece propendere per un’ipotesi che “si direbbe un compromesso tra una teoria ondulatoria ed una teoria corpuscolare, particelle precedute da onde, le quali in certo qual modo, predeterminano il comportamento futuro delle particelle”.

Così scriveva Newton:

“I raggi di luce incidendo su una superficie riflettente o rifrangente, eccitano vibrazioni nel mezzo riflettente o rifrangente … le vibrazioni così eccitate si propagano nel mezzo riflettente o rifrangente, in modo analogo alle vibrazioni del suono nell’aria … ; quando ciascun raggio è in quella parte della vibrazione che è favorevole al suo moto, si fa strada attraverso una superficie rifrangente, ma quando si trova nella parte contraria della vibrazione che impedisce il moto, è facilmente riflesso … .” (273)

E’ solo nella parte finale dell’ Ottica, nelle Questioni 28, 29 e 30, che Newton avanza, come ipotesi da investigare, la sua nota teoria corpuscolare della luce. E’ superfluo notare che ogni ipotesi di Newton è legata ad una possibile, ma non definitiva e neanche tanto importante, spiegazione dei fatti sperimentali noti e via via osservati. Così, mentre l’ipotesi onda-particella, vista qualche riga più su, serviva a Newton per rendere conto e della colorazione delle lamine sottili e del fenomeno degli anelli (che portano il suo nome), la teoria corpuscolare discendeva da una spiegazione che Newton tentava di dare della diffrazione. (274) L’inflessione che un raggio di luce subisce Quando passa, ad esempio, al di là di un forellino è interpretata come il risultato di forze attrattive o repulsive tra la materia costituente il corpo diffrangente ed il raggio luminoso (che per questo è pensato costituito da corpuscoli che, in quanto dotati di massa, subiscono l’azione delle forze attrattive o repulsive).

” Si comprende come l’incentivo verso una concezione corpuscolare della luce, fosse veramente molto forte. Tanto più che l’ipotesi ondulatoria, [come vedremo] già avanzata da Huygens, in mancanza [della conoscenza del fenomeno e] del concetto di interferenza, prestava il fianco ad obiezioni veramente serie, riguardo alla difficoltà di interpretare la propagazione rettilinea.” (274 bis)

Quindi, il tentativo di spiegazione dei fenomeni di diffrazione unito al fatto che, secondo Newton, è impensabile una teoria che voglia la luce fatta di onde (“di pressioni“) perché le onde (“le pressioni“) ” non possono propagarsi in un fluido in linea retta” (275) poiché hanno la tendenza a sparpagliarsi dappertutto, (276) porta il nostro alla formulazione (dubitativa) della teoria corpuscolare che si trova nella Questione 29 dell’Ottica, introdotta con queste parole;

“Non sono i raggi di luce corpuscoli molto piccoli emessi dagli oggetti luminosi ? Infatti questi corpuscoli passeranno attraverso i mezzi omogenei in linea retta senza essere piegati nelle zone d’ombra, com’è nella natura dei raggi di luce.” (276 bis)

Newton passava quindi ad illustrare alcune proprietà degli ipotetici corpuscoli materiali affermando che essi agirebbero a distanza allo stesso modo dell’attrazione reciproca tra i corpi. I colori della luce ed i diversi gradi di rifrangibilità sono poi spiegati con l’ammissione che la luce bianca sia formata da corpuscoli di diversa grandezza (“i più piccoli producono il viola … e gli altri facendosi sempre più grandi, producono” via via gli altri colori fino al rosso). Infine, con questa teoria, è possibile spiegare il fenomeno della doppia rifrazione che, come vedremo, Huygens non era riuscito a spiegare con la teoria ondulatoria). In definitiva, in questo modo, la teoria della luce veniva ricondotta alla più vasta spiegazione che la gravitazione universale doveva fornire.

Riguardo ad Huygens va detto che il suo Trattato sulla luce fu pubblicato nel 1691 ma fu scritto intorno al 1676. (277) In questo lavoro, a chiusura del primo capitolo, fa la sua comparsa la teoria ondulatoria. Allo stesso modo del suono, dice Huygens, la luce deve essere un fenomeno vibratorio e cosi come l’ aria sostiene il suono, altrettanto fa l’etere con la luce (278) (l’etere è qui inteso come una materia estremamente sottile e perfettamente elastica).

Così scriveva Huygens:

“Ogni punto di un corpo luminoso, come il Sole, una candela o un carbone ardente, emette onde il cui centro è proprio quel punto … ; i cerchi concentrici descritti intorno ad ognuno di questi punti rappresentano le onde che si generano da essi … Quello che a prima vista può sembrare molto strano e addirittura incredibile è che le onde prodotte mediante movimenti e corpuscoli cosi piccoli possano estendersi a distanze tanto grandi, come, per esempio, dal Sole o dalle stelle fino a noi … Cessiamo però di meravigliarci se teniamo conto che ad una grande distanza dal corpo luminoso una infinità di onde, comunque originate da differenti punti di questo corpo, si uniscono in modo da formare macroscopicamente una sola onda che, conseguentemente, deve avere abbastanza forza, per farsi sentire.” (279)

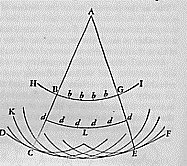

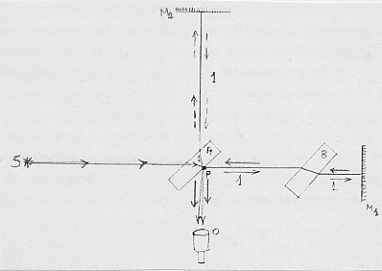

Possiamo riconoscere in queste poche righe la formulazione moderna della teoria ondulatoria fino al principio di Huygens o dell’inviluppo delle onde elementari. Lo stesso Huygens illustra questo principio con la figura 15 che ha il seguente significato: “se DCEF è una onda emessa dal punto luminoso A, che è il suo centro, la particella B, una di quelle che si

Figura 15

trovano all’interno della sfera delimitata da. DCEF, avrà fatto la sua onda elementare KCL che toccherà l’onda DCEF in C, allo stesso momento in cui l’onda principale, emessa da A, raggiunge DCEF; è chiaro che l’unico punto dell’onda KCL che toccherà l’onda DCEF è C che si trova sulla retta passante per AB. Allo stesso modo le altre particelle che si trovano all’interno della sfera delimitata da DCEF, come quelle indicate con b e con d, avranno fatto ciascuna una propria onda. Ognuna di queste onde potrà però essere solo infinitamente debole rispetto all’onda DCEF, alla cui composizione contribuiscono tutte le altre con la parte della loro superficie che è più distante dal centro A.” (280)

Quanto abbiamo ora detto può essere riassunto da quanto già sappiamo e cioè che ogni punto in cui arriva una vibrazione diventa esso stesso centro di nuove vibrazioni (onde sferiche); l’inviluppo di un gran numero di onde elementari, originate in questo modo, origina un nuovo fronte d’onda, con centro la sorgente, molto più intensa, delle onde elementari che la compongono. Huygens proseguiva affermando che con questo modo di intendere le cose, si spiegherebbero tutti i fenomeni ottici conosciuti passando poi a dare le dimostrazioni delle leggi della riflessione, della rifrazione, della doppia rifrazione e della propagazione rettilinea della luce. (281) Quando passava però a dare una spiegazione dei fenomeni che oggi si spiegano con la polarizzazione egli molto semplicemente affermava che non gli era stato possibile trovare nulla che lo soddisfacesse. (282) Riguardo poi alla natura di queste onde ed al loro modo di propagazione, Huygens diceva:

“Nella propagazione di queste onde bisogna considerare ancora che ogni particella di materia da cui un’onda si diparte, deve comunicare il suo movimento non solo alla particella vicina …, ma lo trasmette anche a tutte quelle altre che la toccano e si oppongono al suo moto.” (282 bis)

E questa è una chiara enunciazione di quella che sarà la più grande difficoltà dell’ottica ondulatoria fino a Maxwell: il fatto che le onde luminose risultavano onde di pressione e quindi longitudinali. L’ammissione, inevitabile, di onde longitudinali e non trasversali impediva di pensare a qualsiasi fenomeno di polarizzazione (e quindi questa difficoltà era alla base di quanto Huygens confessava di non saper spiegare). Questo punto era ben presente a Newton che nell’Ottica lo cita e ne tenta una spiegazione ammettendo che i raggi di luce abbiano dei «lati» ciascuno dei quali dotato di particolari proprietà. Se infatti si va ad interpretare un fenomeno di polarizzazione mediante onde longitudinali, non se ne cava nulla poiché “queste onde sono uguali da tutte le parti“. E’ necessario dunque ammettere che ci sia una “differenza … nella posizione dei lati della luce rispetto ai piani di rifrazione perpendicolare.” Come già accennato solo la natura trasversale delle onde elettromagnetiche avrebbe potuto rendere conto, fino in fondo, dei fenomeni di polarizzazione.

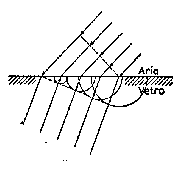

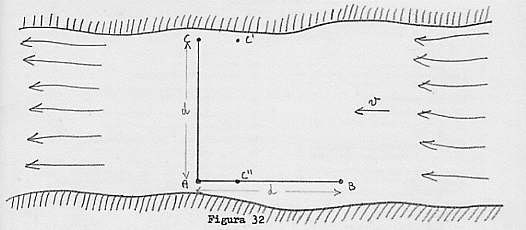

C’è un altro aspetto che differenzia radicalmente la teoria ondulatoria da quella corpuscolare e riguarda la spiegazione del fenomeno di rifrazione (nel passaggio, ad esempio, da un mezzo meno ad uno più denso).

Secondo la teoria corpuscolare l’avvicinamento alla normale del raggio rifratto è spiegato “supponendo che i corpuscoli di luce subiscano un’attrazione da parte del mezzo più denso nel momento in cui vi penetrano. In tal modo essi vengono accelerati sotto l’azione di un impulso perpendicolare alla superficie di separazione e quindi deviati verso la normale. Me consegue che la loro velocità è maggiore in un mezzo più denso che in uno meno denso. La costruzione di Huygens basata sulla teoria ondulatoria, parte da presupposti esattamente contrari (fig. 16). Quando un’onda luminosa colpisce una superficie di separazione, genera in ogni punto della superficie un’onda elementare;

Figura 16

se queste si propagano più lentamente nel secondo mezzo che è il più denso, l’inviluppo di tutte le onde sferiche, che rappresenta l’onda rifratta … è deviato verso destra.” (283) Anche questo quindi diventava un elemento cruciale per decidere sulla maggiore o minore falsicabilità di una. teoria. Se si fosse riusciti a determinare la velocità della luce in mezzi di diversa densità si sarebbe stati in grado di decidere quale teoria fosse più vera.

Fin qui le elaborazioni a monte. Abbiamo già visto che, durante il ‘700, l’ottica non fa importanti progressi, se si escludono alcune questioni di rilievo che provenivano da osservazioni astronomiche (aberrazione della luce) ed il perfezionamento di tutta una serie di strumenti ottici (introduzione lenti acromatiche, telescopi più grandi, fotometri, …). In ogni caso, in linea con tutti gli altri campi della ricerca fisica, i newtoniani decidono che Newton era un corpuscolarista e pertanto è la teoria corpuscolare della luce che trionfa (anche se coloro che portarono avanti queste idee abbandonarono l’altro punto che qualificava la teoria corpuscolare di Newton: il fatto cioè che il moto dei corpuscoli costituenti la luce originasse vibrazioni di un ipotetico etere). Questa scelta ha anche una giustificazione pratica di primo piano ed è che la teoria corpuscolare spiegava, più cose di quella ondulatoria; in particolare era molto più immediato con la prima teoria intendere la propagazione rettilinea della luce che, con la seconda, risultava piuttosto confusa (e, come abbiamo visto, non soddisfaceva neppure Huygens).

Proprio agli inizi dell’Ottocento un giovane medico britannico scoprì un fenomeno *incredibile*; luce sommata a luce, in alcune circostanze, origina buio! E’ il fenomeno dell’interferenza (284) che fu scoperto nel 1802 da Thomas Young (1773-1829). (285) Il modo più semplice di provocare interferenza è

” quando un raggio di luce omogenea (286), scriveva Young, cade sopra uno schermo su cui sono stati praticati due piccoli fori o fenditure, che si possono considerare come centri di divergenza, dai quali la luce è diffratta in tutte le direzioni. In questo caso, quando i due raggi, nuovamente formatisi, vanno ad essere intercettati su una superficie interposta lungo il loro cammino, la loro luce risulterà suddivisa da bande scure in porzioni approssimatamente uguali.” (287)

Anche Young si serviva di modelli meccanici e quello a cui egli si rifaceva per dar ragione di quanto avviene nell’ipotesi ondulatoria, è quello delle onde di acqua in uno stagno. Se due serie uguali di onde, provocate sulla superficie dell’acqua in punti a distanza opportuna, si incontrano, accadrà, egli osservava, che andranno a combinarsi in qualche modo. In ogni punto della superficie dell’acqua lo stato vibratorio risultante dipenderà dal modo in cui vanno a sommarsi o a sottrarsi gli effetti delle onde sovrapposte. E così, se le onde andranno a sommarsi, sovrapponendosi in concordanza di fase esse origineranno un’onda più grande delle due componenti prese separatamente; al contrario, se esse andranno ad incontrarsi in opposizione di fase, si distruggeranno l’un l’altra in modo da originare un’onda nulla (acqua immobile).

Conseguentemente, il principio d’interferenza per la luce era così enunciato:

“Quando due parti di una stessa luce raggiungono l»occhio seguendo due diversi percorsi di direzioni molto vicine, l’intensità è massima quando la differenza dei cammini percorsi è un multiplo di una certa lunghezza; essa è minima per lo stato intermedio.” (287 bis)

A questo punto Young passava, a calcolarsi la lunghezza d’onda dei vari colori costituenti la luce (288) a spiegare con la teoria ondulatoria i diversi fenomeni ottici conosciuti

Anche qui egli incontrò grande difficoltà a rendere conto della propagazione rettilinea della luce: ma la difficoltà insormontabile restava sempre quella della spiegazione tramite la teoria ondulatoria ed usando di onde longitudinali (che Young, in analogia con il suono, riteneva essere caratteristiche della luce) dei fenomeni che oggi chiamiamo di polarizzazione.

Proprio in quegli stessi anni, nel 1808, il fisico francese E.M. Malus (l775-l8l2) riuscì a mettere in evidenza l’esistenza della polarizzazione attraverso fenomeni di riflessione: un raggio di luce riflesso si comporta come uno dei raggi birifratti dallo spato d’Islanda e cioè non subisce più la doppia rifrazione se fatto passare di nuovo attraverso un cristallo dello stesso tipo. La spiegazione che Malus dava del fenomeno è riconducibile a quella newtoniana dei lati delle particelle, infatti egli pensava che i corpuscoli luminosi fossero asimmetrici e si orientassero sia durante la riflessione, sia durante una birifrazione, in modo da non potersi più orientare per successive riflessioni o birifrazioni.

Naturalmente la teoria corpuscolare era sostenuta da gran parte della scuola dei fisici-matematici francesi (288 bis) tra cui Biot e Poisson (che tenteranno in tutti i modi, senza però riuscirvi, di ricondurre i fenomeni di interferenza alla teoria corpuscolare), Laplace e, per un certo tempo, Arago. (289) E fu proprio quest’ultimo che, in un ambiente generalmente ostile, dette un importante sostegno al fisico che doveva dare nuovo impulso alla teoria ondulatoria fino a portarla al suo trionfo: Augustin Fresnel (1788-1827).

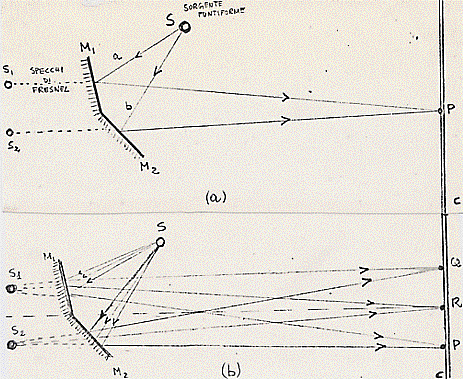

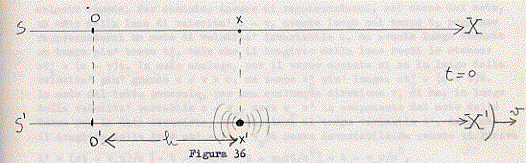

Venuto a conoscenza dell’esperimento di Young proprio da Arago, questo fisico profondamente meccanicista, si propose di indagarlo meglio. Poteva sorgere il dubbio, infatti, che le frange d’interferenza osservate non fossero altro che fenomeni di diffrazione provocati dal passaggio della luce nei piccoli forellini. Egli trovò così un altro modo di produrre interferenza che non poteva far sorgere dubbi. Anziché usare i forellini di Young fece riflettere (l8l6) un raggio di luce, proveniente da una sorgente puntiforme, su due specchi consecutivi formanti tra loro un angolo prossimo a 180° nel modo indicato in figura 17(a) e (b).

Figura 17

Riferendoci alla figura 17 (a), un raggio (onda) luminoso a emesso dalla sorgente puntiforme S, si riflette sullo specchio M1 e si dirige verso il punto P dello schermo C. Analogamente esisterà un altro raggio (onda) b, proveniente da S che si dirigerà verso P, Poiché i cammini dei due raggi sono differenti, i due raggi, in generale, risulteranno sfasati tra loro. Nel caso in cui vi sia concordanza di fase tra le due onde, P sarà un punto in cui si avrà un massimo di illuminazione; nel caso in cui le due onde siano in opposizione di fase, in P vi sarà buio; nel caso di sfasature diverse vi sarà una variazione dell’ intensità dell’illuminazione dal buio al massimo di cui dicevamo. L’effetto complessivo sarà un fenomeno d’interferenza, analogo a quello che sarebbe generato da due sorgenti puntiformi S1 ed S2 , (289 bis) che si osserverà sullo schermo C.

La figura 17(b) mostra invece più onde che vanno ad interferire in diverso nodo sullo schermo C. A seconda del tipo di interferenza, e quindi di sfasatura, tra le onde interessate, i punti P, Q, R saranno bui o illuminati a varie intensità.

Con questa esperienza Fresnel sgombrò contemporaneamente il campo sia dall’interpretazione erronea del fenomeno dovuta ai corpuscolaristi (le frange non hanno nulla a che vedere con l’interazione di tipo gravitazionale tra le pretese particelle di luce ed i bordi delle fenditure) sia da quella altrettanto erronea di Young (le frange non sono generate dall’interferenza delle onde dirette con quelle riflesse dai bordi delle fenditure). La chiave della corretta interpretazione di Fresnel fu proprio la ripresa del principio di Huygens: ogni punto di una superficie di un’onda può diventare fonte di onde secondarie. Ebbene, nel fenomeno d’interferenza creata con due forellini, ciascun forellino diventa sorgente di onde; sono le onde che provengono da un forellino che interferiscono con quelle che si dipartono dall’altro.

Ma fin qui le onde luminose pensate da Fresnel erano longitudinali. Egli, nella sua memoria del l8l6, diceva: “in ogni punto dello spazio dove sta condensato, l’etere è compresso e tende ad espandersi in tutte le direzioni“, e queste non sono altro che onde longitudinali.

Proprio nel l8l6, però, lo stesso Fresnel, insieme ad Arago, scopre che due raggi polarizzati sullo stesso piano interferiscono, mentre se sono polarizzati su piani tra loro perpendicolari non interferiscono più. Il risultato di questa esperienza fu conosciuto da Young il quale, in una lettera ad Arago (l8l7), avanzò l’ipotesi che le onde luminose fossero onde di tipo trasversale. Arago ne informò Fresnel il quale fece sua l’ipotesi e cominciò a lavorarvi con gran lena. Tra il 1821 ed il 1823 egli riuscì a dimostrare che, con questa ipotesi, era possibile spiegare tutti i fenomeni ottici conosciuti. (290) La stessa propagazione rettilinea poi, che era stata sempre un grosso problema per la teoria ondulatoria, interpretata correttamente mediante i fenomeni d’interferenza (il movimento che un’onda sferica trasmette si distrugge in parte per interferenza), non rappresentava più un problema per questa teoria.

Di problema, semmai, ne nasceva un altro e fu lo stesso Fresnel a prospettarlo nel l821. Ammesse le onde trasversali che così bene spiegavano tutti i fenomeni ottici, che caratteristiche avrebbe dovuto avere l’etere per permettere il loro passaggio ? Le onde longitudinali marciano bene in un fluido, ma per le onde trasversali occorre un solido e neppure un. solido qualunque. Questo solido dovrebbe avere una rigidità teoricamente infinita (vista l’enorme velocità di propagazione della luce), quindi più elevata di quella dell’acciaio, e nel contempo deve essere più, evanescente di ogni gas conosciuto per non offrire resistenza ai corpi celesti che da secoli vediamo muoversi nel cielo senza apprezzabili rallentamenti. (291) Fresnel comunque non ebbe modo di seguire il corso degli eventi: nel 1827, a soli 39 anni, morì. Ma la strada ad una gran mole di ricerche sia teoriche che sperimentali era aperta. In particolare l’analogia tra onde luminose ed onde elastiche, che scaturiva dalla teoria di Fresnel, apriva un vasto campo di ricerche sui fenomeni dell’elasticità. (292).

All’obiezione, prima vista, di quella strana doppia natura dell’etere, cercò di rispondere G. Stokes nel 1845, Secondo Stokes la rigidità à relativa e vi sono solidi, come il gesso e la ceralacca, che se da una parte sono rigidi tanto da trasmettere vibrazioni trasversali, dall’altra sono compressibili ed estensibili (risultando molto fragili all’urto meccanico). Si tratta solo di combinare opportunamente le caratteristiche che l’etere solido deve avere per far si che abbia la rigidità richiesta unitamente all’estrema sottigliezza. (293)

Di questi tentativi ne furono fatti tanti (294) e dal corpo della loro elaborazione analitica, con la matematica sviluppata dalla scuola francese nel ‘700, con quella sviluppata dai Green e dagli StoKes in Gran Bretagna e con altra che via via veniva ideata allo scopo, scaturirono moltissimi teoremi che furono poi di grande utilità per gli sviluppi ulteriori della fisica (un esempio di ciò l’abbiamo già visto con Maxwell).

Altro campo di ricerche aperto dalla polemica onde o corpuscoli era quello relativo alla velocità della luce. Non dimentichiamo quanto abbiamo scritto qualche pagina indietro: la spiegazione della rifrazione mediante la teoria corpuscolare prevede che la velocità della luce sia più grande nei mezzi più densi, esattamente il contrario di quanto previsto dalla teoria ondulatoria. C’è l’opportunità di un esperimento cruciale che possa decidere quale teoria descrive meglio i fatti sperimentali osservati. (295) Fino a circa la metà dell”800 però le uniche misure della velocità della luce (che da ora indicherò direttamente con c) erano state eseguite su fenomeni astronomici.

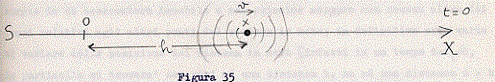

Nel 1676 Roëmer, confrontando le immersioni ed emersioni dall’ombra di Giove del suo satellite Io, notò che l’intervallo tra due eclissi successive era con regolarità minore quando la Terra si avvicinava a Giove e maggiore quando la Terra si allontanava da questo pianeta. Roëmer spiegò questo fatto ammettendo che la luce avesse una velocità finita di propagazione e dopo una serie di accurate osservazioni riuscì a darne il valore.

Nel 1728. Bradley, osservando un gran numero di stelle, si accorse che esse erano dotate di un moto apparente sulla volta celeste: nel corso di un anno esse descrivevano sulla volta celeste una piccola ellissi (a questo fenomeno si dà il nome di aberrazione). Partendo da questo fenomeno e dopo accurati calcoli, Bradley riuscì a fornire una nuova determinazione di c.

Ma nonostante queste importantissime misure effettuate sfruttando fenomeni astronomici, non si era ancora trovato il modo di misurare c sulla Terra: il suo elevato valore fa si che la luce percorre tragitti lunghissimi in tempi brevissimi e tragitti di tale lunghezza non esistono in natura sulla Terra (296) a meno di realizzarli con particolari artifici.

Il primo strumento in grado ai permettere misure di c sulla Terra, che appunto si serviva degli artifici suddetti, fu ideato dal fisico francese H. Fizeau (1819-1896) nel 1849. L’esperienza di Fizeau permise la misura di c nell’aria ma fu impossibile realizzarla in un altro mezzo perché la distanza su cui Fizeau aveva operato in questa sua prima esperienza, era di circa 9.000 metri. (297)

Chi riuscì ad effettuare la misura di c, non solo sulla Terra, ma nei limiti ristretti di una stanza di laboratorio, fu l’altro fisico francese, L. Foucault (1819-1868), nel 1850.(298) L’essere riusciti a portare questa misura in laboratorio apriva la strada, immediatamente percorsa, alla misura di c in diversi mezzi ed. in particolare nell’acqua.

L’esperienza fu eseguita prima in aria, poi in acqua, sia da Foucault che da Fizeau, ed il risultato comparativo della velocità c dava ragione alla teoria ondulatoria: la luce viaggiava, con una velocità minore nei mezzi più densi ed in particolare nel!’acqua risultava essere circa i 3/4 di quanto non fosse nell’aria.

Questo argomento sembrò decisivo: la teoria corpuscolare (od emissiva) non sembrava più conciliabile con la realtà dei fatti sperimentali.

L’ammissione della nuova teoria comportava però nuove difficoltà. Già abbiamo visto le strane proprietà di cui doveva essere dotato questo etere, contemporaneamente estremamente rigido e sottile, e già abbiamo detto che sulla strada del tentar di risolvere questi problemi si erano mossi una gran quantità di fisici-matematici, elaborando la cosiddetta teoria, elastica dell’ottica. L’altro problema che si apriva fu individuato dallo stesso Fresnel in collaborazione con Arago, in una corrispondenza che si scambiarono nel l8l8. Avverto, subito che è una questione di estrema importanza per gli sviluppi futuri di questo lavoro e quindi merita di essere seguita con particolare attenzione anche perché l’argomento è delicato.

NOTE

(269) Per ampliare quanto diremo e per uno studio più approfondito dei problemi si può vedere l’importante lavoro di V. Ronchi (bibl. 86). Per studiare da un punto di vista analitico completo i vari fenomeni discussi ci si può rifare a bibl. 88.

(270) Si veda la nota (°) al cap. 1° e bibl. 3, pagg. 99-102. Alcune delle cose che aggiungerò qui, a proposito di Descartes, Newton ed Huygens, ed in particolare quanto riportato tra virgolette senza indicazione bibliografica, sono ispirate o tratte da bibl. 15, cap, 4.

(271) Le teorie ottiche di Descartes sono esposte nella Diottrica del 1637.

(272) Anche qui, come per le altre vicende riguardanti Newton (e non solo), bisogna distinguere tra Newton ed i newtoniani. Molto spesso si tende a confondere la posizione di Newton con quella che i suoi pretesi sostenitori volevano accreditare. Si capisce certamente la maggiore facilità che ha un preteso storico ad andare avanti per etichette: io non intendo sottoscrivere questo modo di procedere che, per amore di aneddotica, racconta cose non vere o quantomeno discutibili (si veda, ad esempio, E. Persico che in bibl. 88, a pagina 79, fa apparire Descartes come padre putativo della teoria corpuscolare). Questo modo di procedere è tipico di coloro che intendono il progresso scientifico procedente per accumulazione successiva di conoscenze e, naturalmente, con una sua precisa linearità di sviluppo.

(273) Bibl. 87, pag. 493.

(274) Questo fenomeno, noto già da tempo, era stato scoperto ed ampiamente studiato da padre Grimaldi (l6l8-l663) e proprio a costui Newton fa riferimento nell’ Ottica. Si osservi che la parola diffrazione fu introdotta dallo stesso padre Grimaldi, mentre Newton non la usò mai preferendo in sua vece il termine inflessione.

(274 bis) Bibl. 90, pag. 195.

(275) Bibl.87, Quest.28, pagg.525-529. Si osservi che Newton respinge qui la teoria ondulatoria affermando che se essa fosse ammessa un raggio di luce che attraversasse un ostacolo, ad esempio un forellino, dovrebbe sparpagliarsi al di là di esso. Non ammette quindi la teoria che gli avrebbe permesso di spiegare le inflessioni della diffrazione senza ricorrere all’interazione luce-materia.

(276) “E, dice Newton, non si è mai vista la luce seguire vie tortuose o penetrare nell’ombra.“

(276 bis) Ibidem, Quest. 29, pag. 529.

(277) Si osservi che già Hooke, a partire dal 1672, era diventato un sostenitore di una concezione ondulatoria della luce (pare che per far ciò si sia ispirato ad alcuni passi di padre Grimaldi nei quali quest’ultimo parlava di ” vibrazione della direzione dei raggi “).

(278) E’ importante dare qui alcuni riferimenti. Il primo che dimostrò che il suono non si propaga nel vuoto fu un discepolo ed amico di Galileo, Gianfrancesco Sagredo (l571-1620). Egli si serviva di una specie di campanello che era situato all’interno di una campana di vetro dalla quale l’aria veniva quasi completamente tirata via per mezzo di un forte riscaldamento. Si osservi che le prime macchine pneumatiche sono del 1650 (Otto von Guericke). Torricelli fece invece notare che un raggio di luce passa attraverso il vuoto. Altro fatto che merita di essere annotato è la scoperta della doppia rifrazione, fatta nel 1669, dal medico danese E. Bartholin (1625-1698) mediante un cristallo detto «spato di Islanda». Da ultimo osserviamo che un allievo di Bartholin, Olaf Roëmer (1664-1710), nel 1676 riuscì a misurare, per la prima volta, la velocità della luce (calcolando i tempi di immersione ed emersione di uno dei satelliti di Giove, Io, nella zona d’ombra del pianeta. Tutto questo per dire che sia Huygens che Newton lavoravano su questioni sulle quali già si avevano dati sperimentali da sottoporre a trattamento teorico e che interessavano diffusamente gli scienziati dell’epoca. E’ da notare infine che un accostamento,come quello fatto da Huygens, della luce con il suono, se da una parte rende ragione di un mezzo che deve sostenere la luce, così cose l’aria sostiene il suono, dall’altra differenzia completamente i due fenomeni. Insomma, visti i lavori di Sagredo, la luce ed il suono si possono supporre della stessa natura solo se si ammette un etere con particolari proprietà.

(279) Bibl. 87, pagg. 560-561.

(280) Ibidem, pag. 562.

(281) La propagazione rettilinea la si può ancora ricavare dalla figura 15 quando si osserva che il raggio luminoso proveniente da A segue una delle traiettorie rettilinee che si irradiano da A (come quella ABC, segnata) e che risultano perpendicolari al fronte d’onda sferico (ed anche Hooke si era mosso su questa strada). Si osservi che proprio sulla propagazione rettilinea Huygens attaccava i corpuscolaristi, anche se non era soddisfatto neppure della sua teoria; secondo il suo modo di vedere la luce, costituita da corpuscoli, che colpisse un oggetto si sparpaglierebbe dappertutto. Si noti poi che, stranamente, Huygens non si sofferma a spiegare la diffrazione: la spiegazione di questo fenomeno poteva diventare di valido sostegno alla sua teoria.

(282) Oggi sappiamo che quando uno dei due raggi (o tutti e due), prodotto dalla doppia rifrazione, viene fatto passare attraverso un altro cristallo di spato d’Islanda, per particolari orientazioni del cristallo, questo raggio non si sdoppia ulteriormente perché è polarizzato. Questa spiegazione non può prescindere dall’ammissione di luce propagantesi per onde trasversali e quindi dalla teoria di Maxwell (un’onda longitudinale non può infatti essere polarizzata !

(282 bis) Ibidem, pag. 561.

(283) Born in bibl.91, pagg.117-118. Le sottolineature sono mie.

(284) Ora, come nel seguito, non mi soffermerò a spiegare fenomeni che compaiono in tutti i testi di fisica per i licei.

(285) Mi piace notare che Young, come Faraday e, come vedremo, Einstein era un outsider. Sarà violentemente attaccato da tutti i fisici ufficiali e ci vorranno degli anni prima che la sua scoperta venga presa in considerazione. La sua posizione di antinewtoniano era una sorta di reazione allo stato di abbandono (del quale abbiamo già detto) in cui, all’epoca, si trovava la scienza britannica. Egli riteneva che non ci si dovesse cullare con Newton, ma avere fantasia ed imboccare strade nuove. Si noti che anche Young non conosceva la matematica ai livelli richiesti dalla fisica ufficiale

(286) Oggi diremmo: monocromatica.

(28?) Bibl. 89, pag. 374. Altri brani originali di Young, che illustrano tra l’altro la sua adesione al dinamismo fisico, si possono trovare in bibl. 56, pagg. 184-195.

(287 bis) Citato in bibl. 19, Vol. 3, pag. 164.

(288) Young fu il primo a tentare questa impresa trovando valori dell’ordine del milionesimo di metro. Questi valori così piccoli per le lunghezze d’onda dei vari colori – rispetto, naturalmente, alle dimensioni degli oggetti macroscopici – lo convinsero del fatto che la luce dovesse propagarsi in linea retta originando ombre nette. Altro fatto notevole, osservato da Young, fu che la velocità della luce emessa da una sorgente intensa è la stessa di quella emessa da una sorgente debole e questo fatto risultava più facilmente spiegabile con la teoria ondulatoria.

(288 bis) Si ricordi che Euler, nonostante fosse sostenitore delle idee di Newton in vari campi, in ottica fu sostenitore della teoria ondulatoria (sono le vibrazioni dell’etere che trasmettono la luce). Per leggere un brano originale di Euler sull’argomento, si veda. bibl. 12, pagg, 63-64.

(289) Arago si convertirà ben presto alla teoria ondulatoria, anche se ad un certo punto non avrà il coraggio di condividerne tutte le conseguenze. Allo stesso modo Laplace, pur non aderendo mai alla teoria ondulatoria, mostrerà grande ammirazione per i lavori di Fresnel. Si noti infine che il britannico David Brewster (l78l-l868) fu un convinto corpuscolarista.

(209 bis) S1 ed S2 sono due immagini virtuali e simmetriche di S. Lo strumento descritto è un particolare tipo di interferometro: più avanti ne incontreremo altri tipi.

(290) A questo punto però Arago si dissocerà da Fresnel perché, per sua stessa ammissione, non ebbe il coraggio di sostenere l’idea di onde trasversali.

(291) Poisson nel 1828 dimostrò che se l’etere fosse stato un quasi-solido, a lato delle vibrazioni trasversali se ne sarebbero originate altre longitudinali e, alla lunga, queste ultime avrebbero sottratto tanta energia da non rendere più visibile la sorgente.

(292) Per approfondire questi aspetti si può vedere bibl.15, fasc.VII (a) e bibl. 91, pagg. 139-150.

(293) Per leggere un brano originale di Stokes sulla natura della luce, si può vedere bibl. 56, pagg. 243-253.

(294) Agli sviluppi della teoria dell’elasticità, ed in particolare alla teoria elastica dell’ottica, contribuirono, oltre al citato Stokes, eminenti personalità del livello di Poisson, Cauchy (1789-1857), Green, Mac Cullagh (1809-1847), fino al già più volte incontrato W. Thomson.

(295) La crucialità di questa eventuale esperienza era stata sostenuta da Arago nel 1838. Si tenga conto che, come vedremo più avanti, anche Arago nel l8l0 aveva tentato un’esperienza che dirimesse la polemica tra teoria corpuscolare ed ondulatoria.

(296) Nel 1607 ci aveva provato Galileo utilizzando un paio di lanterne e la distanza esistente tra due colline vicine. Naturalmente non riuscì.

(297) Tra le località parigine di Montmatre e Suresne (8.633 metri).

(298) Mentre Fizeau si servì della rotazione di una ruota dentata, Foucault si servì di uno specchio ruotante (mosso da vapore!). Come già accennato nelle pagine precedenti, lo stesso metodo di specchio ruotante era stato per la prima volta utilizzato da Wheatstone nel 1834 per la determinazione della durata di una scintilla elettrica. Fu quest’ultimo che suggerì che lo stesso metodo poteva usarsi per la misura di c e fu Arago che ne trasse spunto ma, data l’età avanzata, lasciò il compito ad altri. Si noti che Foucault ripeté l’esperienza nel 1862 per dare il valore assoluto di c e trovando un valore molto vicino a quelli oggi accettati (298.000 km/sec). Gli anni che vanno dal 1850 al 1862 furono per Foucault densi di altri lavori: in particolare, nel 1851 ideò il famoso pendolo (che porta il suo nome) con il quale dimostrò la rotazione della Terra sul proprio asse (dai tempi di Copernico, la prima prova terrestre di ciò). Altro merito importante che va ascritto a Foucault è la scoperta delle correnti parassite.

(299) Allo scopo mi servirò diffusamente di bibl. 81, pagg. 183-192 e di bibl. 91, pagg. 150-180.

(300) E’ il fatto che la luce passa anche attraverso i corpi (si pensi a quelli trasparenti) che fa ipotizzare l’etere anche dentro i corpi. Si noti che per Huygens risultò una grossa difficoltà lo spiegare la differenza tra corpi trasparenti e corpi opachi (allo scopo si veda bibl.l5, Cap.4, pag.l5 e bibl.86, pagg. 199-200).

(301) Ricordo una delle possibili formulazioni di tale principio: “Le leggi della meccanica hanno la stessa forma in tutti i sistemi inerziali “. Per capire meglio quanto qui sostenuto si può leggere l’altro mio lavoro sull’ argomento (La relatività da Aristotele a Newton – Bibl.3, pagg. 129-144).

(302) Bibl. 91, pagg. 150-151.